喜闻乐见基准测试

Qwen3 在多个权威基准测试中,与 DeepSeek-R1 和 OpenAI 的主流模型(如O1、O3-mini)均处于同一梯队,甚至在部分任务上实现了超越。例如,Qwen3-32B 在 LiveBench 准确率等测试中超过了 OpenAI O1,同时在工具调用、指令跟随和数据格式复制等方面表现突出:

| 测试项目 | Qwen3-235B-A22B | Qwen3-32B | DeepSeek-R1 | OpenAI-o1 | OpenAI-o3-mini |

|---|---|---|---|---|---|

| ArenaHard | 95.6 | 93.8 | 93.2 | 92.1 | 89.0 |

| AIME’24 (数学) | 85.7 | 81.4 | 79.8 | 74.3 | 79.6 |

| AIME’25 (数学) | 81.5 | 72.9 | 70.0 | 79.2 | 74.8 |

| LiveCodeBench | 70.7 | 65.7 | 64.3 | 63.9 | 66.3 |

| CodeForces (编程) | 2056 | 1977 | 2029 | 1891 | 2036 |

| LiveBench (综合) | 77.1 | 74.9 | 71.6 | 75.7 | 70.0 |

| MultiIF (多语) | 71.9 | 73.0 | 67.7 | 48.8 | 48.4 |

来源:https://qwenlm.github.io/blog/qwen3/

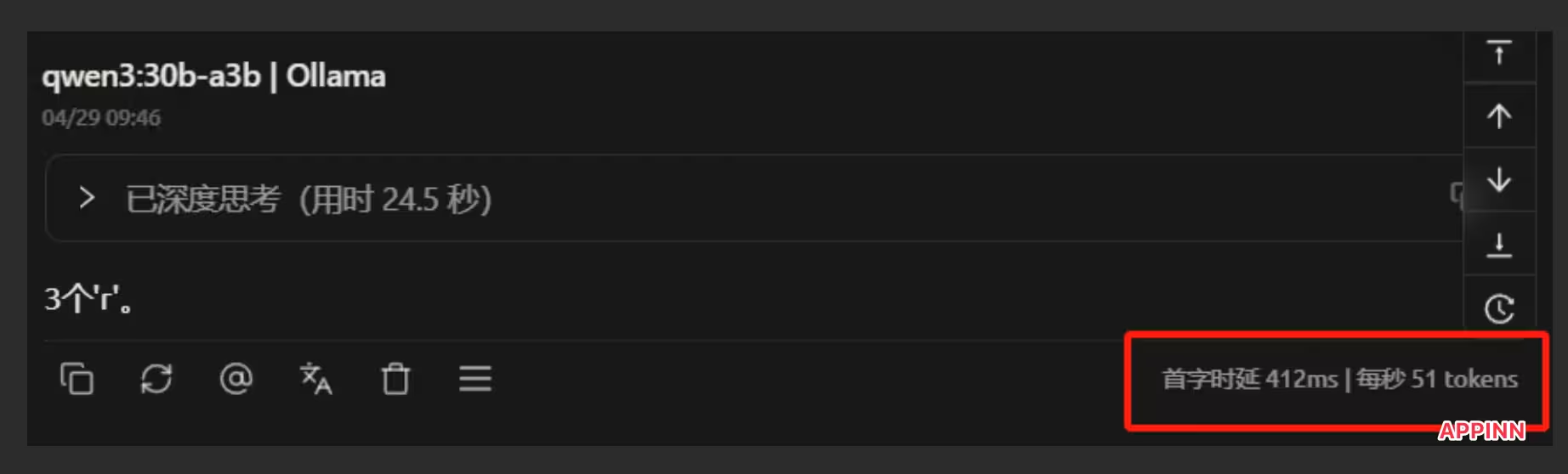

喜闻乐见实测

小众软件群里的 smallpig 同学在自己的 4090 24GB 单显卡上实测,使用 Qwen3-30B-A3B 模型,实现了其他 3B 模型的速度,但是质量有 30B。

这意味着个人用户在自己家中跑可以正常使用的大模型,不再是什么大问题了。

主要结论

综合能力

Qwen3-235B-A22B 在绝大多数基准测试(如 ArenaHard、AIME’24、AIME’25、LiveBench、MultiIF)均取得了当前主流开源模型中的最高分,整体表现优于 DeepSeek-R1 和 OpenAI-o1,甚至在部分任务上超越了 Gemini 2.5-Pro 和 Grok 3 Beta 等闭源大模型。

数学与推理

Qwen3-235B-A22B 在数学类测试(AIME’24/25)和推理类任务上成绩领先,尤其适合高难度 STEM 场景。

编程能力

在 Codeforces 编程 Elo Rating 上,Qwen3-235B-A22B(2056)与 DeepSeek-R1(2029)、OpenAI-o3-mini(2036)处于同一梯队,均为顶级水平。

多语言能力

Qwen3 在 MultiIF(8语种推理)测试中表现突出,显示其多语言能力极强,远超 OpenAI-o1、o3-mini 等模型。

中小模型表现

Qwen3-30B-A3B、Qwen3-32B 在绝大多数任务上也均优于同参数量的 DeepSeek-V3、Gemma、Qwen2.5-72B-Instruct 等开源模型,且小模型性能提升明显。

Qwen3 正式发布,共开放8款模型,包括2个Mixture-of-Experts(MoE)模型和6个密集模型,参数规模覆盖0.6B到235B,适配从移动端到云端的多场景需求。

Qwen3最大亮点在于“混合思考模式”:用户可根据任务复杂度,在“思考模式”(逐步推理,适合复杂问题)和“极速模式”(高效直答,适合简单问题)之间灵活切换,还能通过 /think和 /no_think 标签动态控制思考深度,实现推理预算的精细调节。

多语言能力显著提升,支持119种语言和方言,覆盖全球主流语种,满足多语环境下的对话、翻译和专业领域需求。预训练数据量达到36万亿tokens,涵盖STEM、代码、推理等多领域,模型在数学、代码、逻辑推理等任务上表现优异,部分小模型已能媲美甚至超越上一代大模型。

Qwen3支持多模态扩展,具备文本、代码、音频、图像等处理能力,并强化了智能体(Agent)工具调用,适合复杂自动化场景。所有模型均采用Apache 2.0开源协议,免费可商用,支持主流推理框架和本地部署,开发者可灵活集成到各类应用中。

原文:https://www.appinn.com/qwen3/

©2025 青小蛙 for 小众软件 | 加入我们 | 投稿 | 订阅指南

3659b075e72a5b7b1b87ea74aa7932ff

点击这里留言、和原作者一起评论