2025年,大模型技术的发展日新月异,成为人工智能领域的重要推动力。OpenAI、字节跳动、腾讯等科技巨头纷纷推出新的模型更新,推动了视觉推理、多模态融合、工具调用等关键领域的进步。本文将深入分析这些大模型的最新动态,探讨其迭代逻辑以及对AI应用的潜在影响,为关注大模型发展的专业人士提供有价值的洞察。

作为一个AI应用的从业人员,过去几个月,三白一直都在寻找一个答案,今年大模型的发展方向会是什么样的,大模型新的突破方向和亮点会是什么?最近几天整个行业层出不穷的大模型更新,包括OpenAI、字节、腾讯等,让我找到了一些头绪,所以今天这篇文章就主要分享一下我认为比较重要的几个大模型更新的内容,以及分享一下目前我观测到的关于大模型发展方向的一些阶段思考。

01 大模型重点动态概览

OpenAI:先后发布O3和O4-mini视觉推理模型、GPT4.1模型、升级版GPT4o;

字节:4月16日发布 豆包深度思考1.5推理模型、豆包文生图3.0、豆包视觉理解模型、GUI Agent大模型、OS Agent解决方案,详细参考豆包1.5·深度思考模型发布一文;

腾讯:公开论文实现长链路视觉推理模型、3D生成模型、视频生成模型、数字人模型、图像编辑模型,详细参考腾讯混元2025CVPR论文全解读:6篇论文速通大模型前沿

接下来我重点解析一下这三家比较有代表性的大模型厂商最近更新的大模型能力细节,帮助大家快速理解都更新了些什么,以及各自背后大模型更新迭代的逻辑是什么样的,对于AI应用方面又会有哪些影响。

02 OpenAI大模型更新动态和迭代逻辑

1.发布O3和O4-mini模型

4月16日,OpenAI发布的O3和O4-mini的更新细节主要包括如下几点:

- 作为第一代视觉推理模型,能够在思维链中使用图像理解的能力,一边看图一边思考和推理;

- 具备图像处理能力,能够将图像旋转、裁剪、放大,从而更加准确的理解和获取图像的内容,即使很细小的信息,也能够被分析到;

- 具备工具调用的能力:OpenAI通过强化学习训练了这两个模型使用工具——不仅教会它们如何使用工具,还教会它们推理何时使用工具

2.发布GPT4.1模型,仅提供API,不上架ChatGPT

4月14日,OpenAI发布GPT4.1模型,该模型为基础模型,本次的更新也没有特别多,主要是一些基础能力的强化,包括:

- 编码能力提升;

- 指令遵循能力提升:更加准确并且严格遵循提示词的要求生成;

- 支持上下文长度支持100万token;

- 它们的知识截止日期已更新至 2024 年 6 月。

3.升级GPT4o多模态大模型

3月25日,OpenAI推出升级版GPT4o多模态大模型,进一步增强了模型的能力,更新内容包括:

1. GPT-4o首次将文本、图像、语音生成能力整合至统一神经网络框架,形成一个综合文本、图像语音一体的多模态模型,能直接端到端的理解和输出多种模态内容;

2. 在生图这个领域,相比之前的DALL·E模型,差异包括生成图像的时候具备直接理解上下文,不需要通过基础模型辅助,原来的DALL·E等图像生成模型,用户需要提供非常精确的提示词才能让模型准确的生成相关的视觉内容,并且生成模型不具备记忆能力,单次生成之后,继续提指令需求的时候,模型生成的结果可能跟原来的没有关系,而多模态的模型可以解决这个问题,真正意义的实现通过对话的方式生成、编辑图片;

3.图像生成性能优化,包括如下:

- 精准文字渲染:复杂设计素材(如Logo、菜单)的文字排版准确率超95%,支持中文等多语言,也就是说,4o也支持了类似豆包的文字海报生成的功能; ◦

- 视觉一致性:通过联合表征学习和上下文感知技术,确保多轮对话中图像风格统一。

- 生成速度:4K图像生成耗时约30秒,较前代缩短50%。

OpenAI的模型迭代总结

- 在推理模型上,支持视觉推理,这个是OpenAI这次模型更新最大的亮点,也是最技惊四座的能力;

- 在基础模型上,重点优化模型以编码为主的逻辑推理能力、上下文长度、严格按照指令生成的能力,这些都还是模型基础能力的进一步提升;

- 在多模态模型上,把文本、语音、图像融合在一起,支持更多的模态,在图像生成领域支持更加精细准确、高清的内容生成,以及解决生图场景中上下文遗失的问题。

03 字节豆包大模型更新动态和迭代逻辑

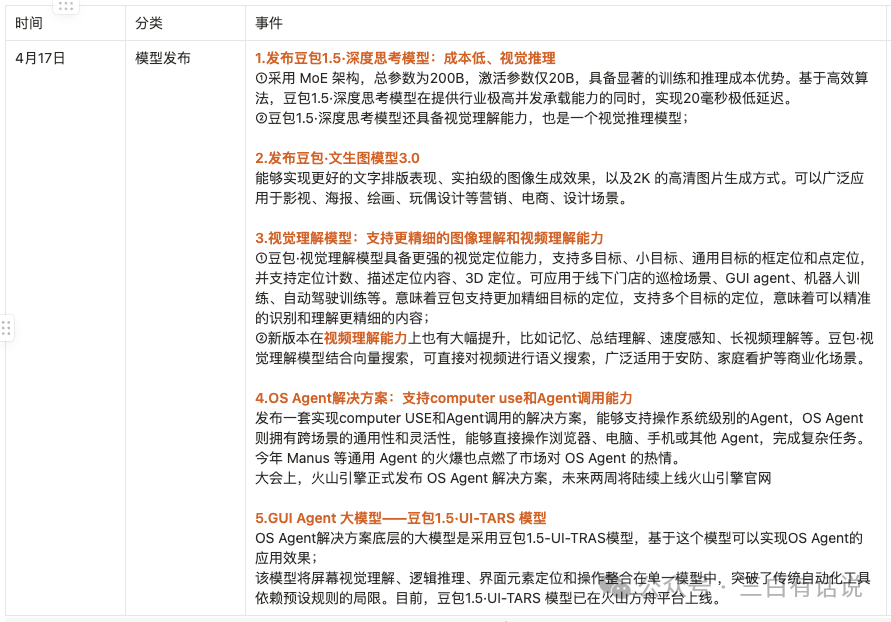

4月17日,字节公布了近期更新的几个模型,因为更新内容比较丰富且技术含量很大,值得重点关注一下,具体内容如下:

1.发布豆包1.5·深度思考模型:成本低、视觉推理

- 采用 MoE 架构,总参数为200B,激活参数仅20B,具备显著的训练和推理成本优势。基于高效算法,豆包1.5·深度思考模型在提供行业极高并发承载能力的同时,实现20毫秒极低延迟。

- 豆包1.5·深度思考模型支持边想边搜,还具备视觉理解能力,也是一个视觉推理模型;

2.发布豆包·文生图模型3.0

- 能够实现更好的文字排版表现、实拍级的图像生成效果,以及2K 的高清图片生成方式。

- 可以广泛应用于影视、海报、绘画、玩偶设计等营销、电商、设计场景。

3.视觉理解模型:支持更精细的图像理解和视频理解能力

- 豆包·视觉理解模型具备更强的视觉定位能力,支持多目标、小目标、通用目标的框定位和点定位,并支持定位计数、描述定位内容、3D 定位。可应用于线下门店的巡检场景、GUI agent、机器人训练、自动驾驶训练等。意味着豆包支持更加精细目标的定位,支持多个目标的定位,意味着可以精准的识别和理解更精细的内容;

- 新版本在视频理解能力上也有大幅提升,比如记忆、总结理解、速度感知、长视频理解等。豆包·视觉理解模型结合向量搜索,可直接对视频进行语义搜索,广泛适用于安防、家庭看护等商业化场景。

4.OS Agent解决方案:支持computer use和Agent调用能力

发布一套实现computer USE和Agent调用的解决方案,能够支持操作系统级别的Agent,OS Agent 则拥有跨场景的通用性和灵活性,能够直接操作浏览器、电脑、手机或其他 Agent,完成复杂任务,未来两周将陆续上线火山引擎官网;

5.GUI Agent 大模型——豆包1.5·UI-TARS 模型

OS Agent解决方案底层的大模型是采用豆包1.5-UI-TRAS模型,基于这个模型可以实现OS Agent的应用效果; 该模型将屏幕视觉理解、逻辑推理、界面元素定位和操作整合在单一模型中,突破了传统自动化工具依赖预设规则的局限。目前,豆包1.5·UI-TARS 模型已在火山方舟平台上线。

字节豆包大模型模型迭代逻辑总结

从前面这些模型的更新上可以看到,目前字节大模型更新迭代的方向上,存在如下几个特点:

1)在基础模型方向,主推深度推理模型,主打的亮点是训练和推理的成本更低,时延更快;

2)在视觉模型方向,主要的迭代方向包括如下几点:

- 支持视觉推理能力:从文本推理领域,开始拓展到视觉推理领域;

- 支持更强大的视觉理解能力:包括支持更加精细的图像理解和定位能力,以及支持视频理解能力;

3)在应用模型方面,主要迭代包括:

- 基于强大的视觉理解、视觉推理的能力,推出了豆包1.5-UI-TRAS模型,能够支持在电脑和手机操作系统入口,实时的获取设备屏幕内容并用于AI应用;

- 基于豆包1.5-UI-TRAS模型,再加上浏览器、电脑、手机或 Agent调用的能力,提供一套实现类似Manus的产品,并且在操作系统入口完整自动化任务应用的解决方案,也就是OS Agent解决方案;

从豆包大模型的更新看豆包未来应用的更新方向

1)基于豆包深度思考模型,未来豆包的应用迭代方向包括

- 支持更强大的DeepSearch(深度搜索)和DeepReSearch(深度研究)应用;

- 基于视觉推理模型,未来可以支持更多依赖图像分析的应用,比如医疗影像分析、图文数据分析、图像比对、图像定位、等应用;

2)基于图像和视频理解模型能力,未来应用迭代的反向包括:

- 更精准、更精细的图片编辑能力:比如针对一些元素复杂的图片,可以精确的识别到很细小的元素,并对该元素做定向编辑;

- 支持实时环境信息、人物情绪的分析;

3)OS Agent解决方案和豆包1.5-UI-TRAS模型,实现类似Manus类产品支持工具和API自动调用的应用;或者是支持在电脑、手机等操作系统级别,支持实时获取屏幕内容并用于AI应用,甚至是支持自动操作操作系统设备,完成自动化任务的应用,这个将在电商、办公、生活等应用场景会有很好的应用结合场景;

04 腾讯混元大模型更新动态和迭代逻辑

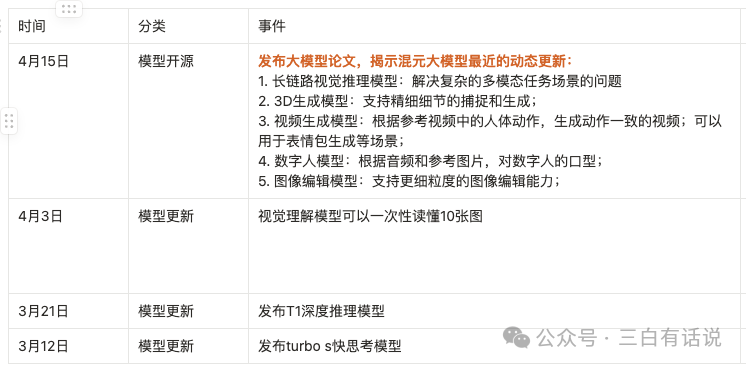

4月15日,腾讯对外公开了6篇关于腾讯混元大模型相关的论文,揭示其大模型最新的进展,具体如下:

发布大模型论文,揭示混元大模型最近的动态更新:

- 长链路视觉推理模型:解决复杂的多模态任务场景的问题

- 3D生成模型:支持精细细节的捕捉和生成;

- 视频生成模型:根据参考视频中的人体动作,生成动作一致的视频;可以用于表情包生成等场景;

- 数字人模型:根据音频和参考图片,对数字人的口型;

- 图像编辑模型:支持更细粒度的图像编辑能力;

对腾讯应用更新方向的思考

- 基于视觉推理模型,未来可以支持更多依赖图像分析的应用;

- 图像AI编辑,可能也是接下来的应用结合方向;

- 支持基于参考视频生成相似视频场景应用,以及基于语音和文字,生成对口型的数字人视频;

05 从各个大模型厂商迭代的角度,总结大模型的迭代方向

在推理模型方面,目前整个行业的迭代方向都是聚焦在视觉推理模型领域

不管是OpenAI的O3,字节豆包1.5深度思考模型,腾讯混元推理模型,都不约而同的朝着视觉推理模型这个方向发展,支持在思维链中使用图像理解的能力,边看图像边思考;

强化模型的工具调用能力

其中,O3通过强化学习训练了最新模型使用工具的能力,不仅教会它们如何使用工具,还教会它们推理何时使用工具;字节豆包1.5深度思考模型,也增强了computer use和Agent调用的能力;

视觉理解方面,支持更加精细的内容识别和视频理解能力

一方面,O3模型、豆包视觉理解模型、腾讯混元生图模型都陆续支持更加细小粒度的视觉内容的识别能力;另一方面,视频理解也是新的迭代方向之一;

图像生成模型方面,支持上下文理解、更精准的文字排版能力、更精细细节的捕捉和生成

06 应用层的一些机会思考

- 依赖视觉推理的应用场景,将获得更好的能力提升,包括深度搜索、深度研究、影像分析、视频聊天、在线教育、AI硬件等;

- 更多的应用将支持工具调用、computer use和Agent调用的能力,Manus类型的应用将越来越多;

- 依赖更精细和细小的视觉识别和理解的应用场景,将得到更好的满足;

- AI生图和AI编辑能力,将能够有更好的产品体验,可以支持到更加精细的元素编辑,以及元素生成的能力,比如细小的字体,纽扣级别元素等;

OK,以上分享一下最近三白关注的AI大模型领域的信息,以及个人的一些随笔思考,希望对于研究和关注大模型领域的朋友有些帮助。

作者:三白有话说,公众号:三白有话说

本文由 @三白有话说 原创发布于人人都是产品经理。未经作者许可,禁止转载。

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。